Tifo sportivo, politica, religione e non solo, sono argomenti che come pochi altri riescono a dividere e polarizzare le persone. «Divide et impera» diceva già più di duemila anni fa qualcuno. Ma come mai l’essere umano, una volta che si è fossilizzato su un’idea, salvo rari casi, non è disponibile a ritrattarla?

In questo articolo cercheremo di dare una risposta alla domanda che ci siamo appena posti.

Psicologia

La difficoltà che proviamo nel cambiare opinione è data principalmente dal alcuni bias più o meno radicati nella psicologia umana. I bias cognitivi altro non sono che costrutti basati su percezioni errate della realtà e/o pregiudizi che di frequente possono portare le persone a fare affermazioni e pensieri errati sui più svariati argomenti.

I bias strettamente legati all’argomento centrale di questo articolo sono i seguenti:

- Bias di conferma: qualunque nuova informazione conferma le nostre convinzioni precedenti, confutando quelle opposte.

- Bias di gruppo: bias che ci porta a sopravvalutare le capacità ed il valore del nostro gruppo di appartenenza, attribuendo perentoriamente alla sfortuna gli eventi negativi e al merito e talento quelli positivi.

- Effetto carovana: rappresenta la tendenza a credere in qualcosa solo perché molte altre persone vicine a noi ci credono (questo fenomeno si sopra bene con la religione e la politica).

- Bias conservativo: ogni novità viene vista con grande sospetto e sottovalutata rispetto alle precedenti convinzioni. Se per esempio leggo una rivista che porta avanti la tesi della nocività del latte di vacca per l’essere umano ed inizio a credere a questa tesi, difficilmente prenderò in considerazione le opinioni di chi smentisce questa nocività, indipendentemente dall’autorevolezza delle fonti.

- Bias di proiezione: percezione distolta della realtà. Riteniamo di pensare e vedere le cose sempre nella maniera giusta e ci sembra che anche le altre persone la pensino come noi (falso consenso).

Questione di cervello

Dietro al mutamento delle idee c’è anche un aspetto se vogliamo più concreto e tangibile, per quanto può essere tangibile un cambiamento strutturale di pochi micron all’interno del cervello.

Quando una nostra opinione ben consolidata viene messa in discussione, attaccata, il nostro cervello si difende. Quasi come se quest’ultimo avesse un sistema immunitario pronto a contrastare ogni pericolo esterno, se per pericolo esterno intendiamo informazioni che rischierebbero di far crollare le nostre certezze. Al riguardo, come asserisce lo psicologo americano Jonas Kaplan: «La responsabilità primaria del cervello è prendersi cura del corpo, proteggere il corpo. Il sé psicologico è l’estensione del cervello. Quando il nostro sé si sente attaccato, il nostro cervello fa valere le stesse difese che ha per proteggere il corpo».

Quanto detto in queste ultime righe vale in particolar modo per le ideologie politiche, dato che esse le percepiamo come qualcosa di fortemente legato alla nostra identità personale, quasi fossero connaturate all’animo umano. Magari le abbiamo ereditate dall’ambiente (familiare e non solo) in cui siamo cresciuti ed abbandonarle, o più semplicemente rivalutarle, ci farebbe sentire indifesi – visto l’attacco al nostro sé – e tremendamente insicuri.

«Un uomo è sempre preda delle proprie verità. Quando le abbia riconosciute, egli non è capace di staccarsene», Albert Camus.

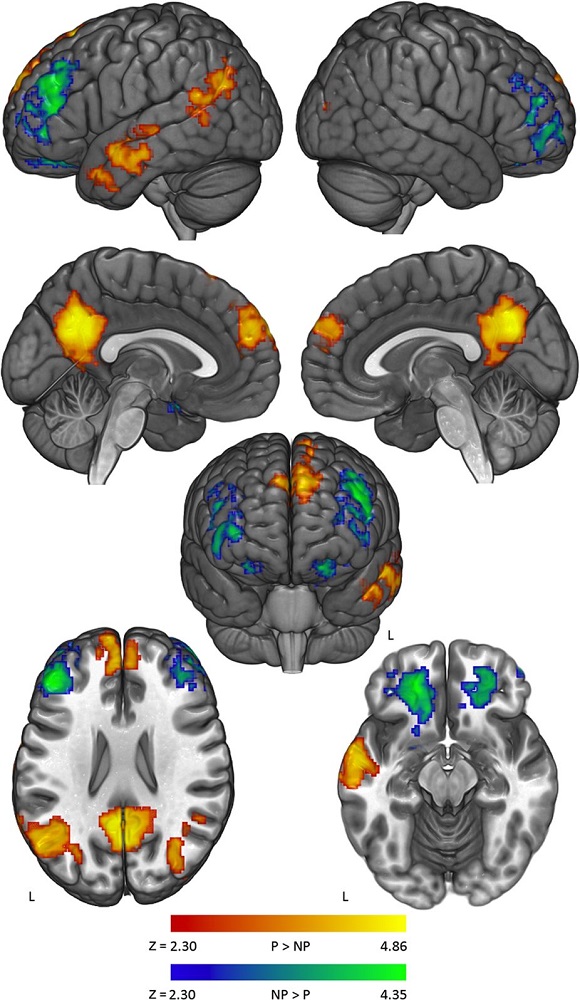

Uno studio discretamente famoso pubblicato su Nature [1] ha mostrato tramite la risonanza magnetica funzionale (RMF) quali sono le aree del cervello maggiormente attive durante un dibattito con una persona che mette fortemente in discussione le nostre convinzioni politiche più radicate (immagine sotto).

Cos’è emerso? Durante i momenti più accesi del dibattito le zone del cervello maggiormente attive erano quelle che si pensava corrispondessero all’identità personale (self-identity) e alle emozioni negative (amigdala). Vedendo la differenza dell’intensità di segnale fra le questioni politiche e non politiche, J. Kaplan e colleghi hanno bollato come “default mode network” l’insieme di strutture cerebrali implicate nel pensare a se stessi, alla propria identità, alla memoria ed al mind-wandering (tendenza della mente a vagare ed a spostare l’attenzione su altro).

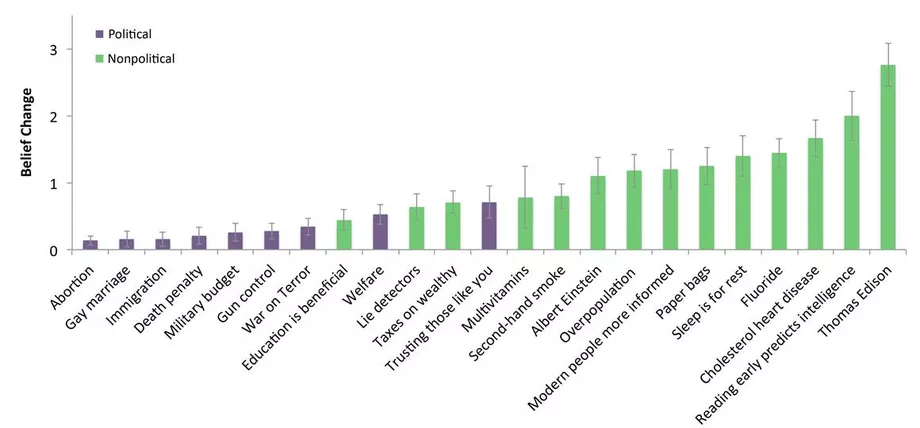

In sintesi, il cervello attiva automaticamente le aree predisposte alla contemplazione di noi stessi ed ai cattivi pensieri e probabilmente lo fa per mettere una sorta di blocco, un ostacolo al cambiamento delle idee più radicate. Le persone dello studio citato poco fa potevano cambiare idea su argomenti non politici dove non avevano grande interesse o credenze solide (ad esempio il valore delle scoperte di Edison o Albert Einstein), ma sulle questioni politiche la cosa era molto più ostica (grafico sotto).

Quando affrontiamo seriamente un dibattito, guardiamo un documentario, leggiamo un libro o ragioniamo su un film appena visto al cinema, il nostro cervello subisce delle modificazioni strutturali. Parliamo ovviamente di cambiamenti minimi, quasi impercettibili, visibili unicamente col microscopio elettronico a scansione. Tutto ciò è garantito dalla plasticità del nostro cervello, ovvero la capacità dell’encefalo di modificare la propria struttura e le proprie funzionalità in base all’attività dei propri neuroni.

Al riguardo ci sentiamo di consigliarvi le seguenti letture: - Menti tribali. Perché le brave persone si dividono su politica e religione (J. Haidt) - Cervello. Manuale dell'utente. Guida semplificata alla macchina più complessa del mondo (Magrini M.) - Flessibilità cognitiva e scelte elettorali (Le Scienze)

Inefficacia del debunking

Proprio a causa dei pregiudizi riportati nel precedente paragrafo il debunking, ovvero quell’insieme di attività che hanno come fine lo smascheramento di bufale (fake news) molto spesso è poco efficace. Ma come mai lo è?

Per rispondere a questa domanda dobbiamo ricollegarci al concetto del bias di conferma. Infatti: «Nel valutare notizie e idee, la nostra mente è più attenta a riconoscersi in un gruppo di appartenenza, che rafforza la nostra identità, che non a valutare l’accuratezza delle informazioni» [2]. Inoltre, il bias di conferma va a nozze con le cosiddette bugie blu, restando in tema politico: «I bambini iniziano a dire bugie egoistiche verso i tre anni, quando scoprono che gli adulti non possono leggere i loro pensieri: non ho rubato quel giocattolo, papà ha detto che potevo, mi ha picchiato lui per primo. A circa sette anni iniziano a dire “bugie bianche” motivate da sentimenti di empatia e compassione: che bello il tuo disegno, i calzini sono un bel regalo di Natale, sei divertente.

Le “bugie blu” appartengono a una categoria del tutto diversa: sono allo stesso tempo egoiste e vantaggiose per gli altri, ma solo se appartengono al proprio gruppo. Come spiega Kang Lee, psicologo all’Università di Toronto, queste bugie cadono a metà fra quelle “bianche” dette per altruismo e quelle “nere” di tipo egoista. “Si può dire una bugia blu contro un altro gruppo”, dice Lee, e questo rende chi la dice allo stesso tempo altruista ed egoista. “Per esempio, si può mentire su una scorrettezza commessa dalla squadra in cui giochi, che è una cosa antisociale, ma aiuta la tua squadra.”

In uno studio del 2008 su bambini di 7, 9 e 11 anni – il primo del suo genere – Lee e colleghi hanno scoperto che i bambini diventano più propensi a raccontare e approvare le bugie blu via via che crescono. Per esempio, potendo mentire a un intervistatore sulle scorrettezze avvenuta durante la fase di selezione delle squadre in un torneo scolastico di scacchi, molti erano abbastanza disposti a farlo, e i ragazzi grandi più di quelli più giovani. I bambini che mentivano non avevano nulla da guadagnare personalmente; lo stavano facendo per la loro scuola. Questa ricerca suggerisce che le bugie nere isolano le persone, le bugie bianche le uniscono, e le bugie blu coalizzano alcune persone e ne allontanano altre. […] Questa ricerca – e queste storie – evidenziano una dura verità sulla nostra specie: siamo creature intensamente sociali, ma siamo inclini a dividerci in gruppi competitivi, in gran parte per il controllo della distribuzione delle risorse. […] “La gente perdona le bugie contro le nazioni nemiche, e dato che oggi in America molte persone vedono quelli dall’altra parte politica come nemici, possono ritenere – quando le riconoscono – che siano strumenti di guerra appropriati”, dice George Edwards, politologo alla Texas A & M e uno dei più importanti studiosi nazionali della presidenza» [3].

Per avviarci alla conclusione del paragrafo, questo meccanismo psicologico è direttamente collegato al concetto della post-verità (post–truth), cioè alla non importanza della veridicità di una notizia. Vera o falsa che sia, l’unico fine di quest’ultima è quello di rafforzare i pregiudizi delle persone. Ecco spiegato il perché dello scarso potere del debunking nel far cambiare idea alle persone su determinati argomenti, anche quando la fake news è lapalissiana.

Come riporta uno noto studio italiano: «I nostri risultati mostrano che i post di debunking rimangono principalmente confinati all’interno della echo-chamber scientifica e solo pochi utenti solitamente esposti a richieste non comprovate interagiscono attivamente con le correzioni. Le informazioni di dissenso vengono principalmente ignorate e, se guardiamo al sentimento espresso dagli utenti nei loro commenti, troviamo un ambiente piuttosto negativo. Inoltre, dimostriamo che i pochi utenti della camera di congiunzione delle cospirazioni che interagiscono con i post di smascheramento manifestano una maggiore tendenza a commentare, in generale. Tuttavia, se osserviamo il loro tasso di commenti e gradimento, cioè il numero giornaliero di commenti e mi piace, scopriamo che la loro attività nella eco-chamber della cospirazione aumenta dopo l’interazione (quindi nonostante lo sbufalamento, la loro passione per i complotti aumenta, ndr).

Pertanto, le informazioni dissenzienti online vengono ignorate. In effetti, i nostri risultati suggeriscono che le informazioni di debunking restano confinate all’interno della camera d’eco scientifico e che pochissimi utenti della camera di eco della cospirazione interagiscono con i post di debunking. Inoltre, l’interazione sembra portare ad un crescente interesse per contenuti di tipo cospirativo.

Dal nostro punto di vista, la diffusione di contenuti fasulli è in qualche modo correlata alla crescente sfiducia delle persone rispetto alle istituzioni, al crescente livello di analfabetismo funzionale, ovvero all’incapacità di comprendere correttamente le informazioni che interessano i paesi occidentali, nonché all’effetto combinato di bias di conferma al lavoro su un enorme bacino di informazioni in cui la qualità è scarsa. Secondo queste impostazioni, le attuali campagne di debunking e le soluzioni algoritmiche non sembrano essere le migliori opzioni. I nostri risultati suggeriscono che il principale problema alla base della disinformazione è il conservatorismo piuttosto che la creduloneria» [4].

Studi ancor più recenti, purtroppo, confermano la scarsa utilità del debunking [5].

Qui un approccio più “filosofico” all’argomento…

Conclusioni

Paradossalmente capire qualche cosa di più sulle nostre vie cognitive ci ha permesso di far luce su alcuni nostri limiti fisiologici ma allo stesso tempo ci ha portato a porci altre domande, nuove paranoie.

Del resto, come diceva il celebre fisico statunitense John Archibald: «Quando cresce l’isola della conoscenza, cresce anche la costa della nostra ignoranza».

Se il nostro cervello cerca di essere conservativo e restio al cambiamento di certe opinioni, è completamente impossibile maturare e cambiarle? Non esiste un modo per aggirare questo blocco? E qualora ci fosse, sarebbe gestibile? Dopotutto, il restare ancorati a certe posizioni è uno stratagemma a cui ricorre la mente umana per darci stabilità, senza venire travolti dal cambiamento.

Chi ha scritto questo articolo non ha le risposte, voi lettori nemmeno ma è proprio questo il bello della scienza (e anche della filosofia), la ricerca eterna di verità a cui probabilmente non si giungerà mai, almeno non in maniera definitiva.

«Bisogna sempre tener presenti questi […] principi: cambiar parere se trovi qualcuno capace di correggerti, rimuovendoti da una certa opinione. Questo nuovo parere, comunque, deve sempre avere una ragione verosimile, come la giustizia o l’interesse comune, come la giustizia o l’interesse comune, ed esclusivamente tali devono essere i motivi che determinano la tua scelta, non il fatto che ti sia parsa più piacevole o tale da procurarti maggior gloria» (Marco Aurelio).

Grazie per l’attenzione.

Bibliografia

1 Kaplan T. J. et al. – Neural correlates of maintaining one’s political beliefs in the face of counterevidence (2016)

2 Le Scienze – Perché crediamo al nostro partito politico (2018)

3 Le Scienze – Perché le “bugie blu” non fanno perdere consensi (2017)

4 Zollo F. et al. – Debunking in a world of tribes (2017)

5 Heidi J Larson, David A Broniatowski – Why Debunking Misinformation Is Not Enough to Change People’s Minds About Vaccines. Am J Public Health. 2021 Jun;111(6):1058-1060.

Magrini M. – Cervello. Manuale dell’utente (Giunti Editore, 2017)

Haidt J. – Menti tribali. Perché le brave persone si dividono su politica e religione (Codice Edizioni, 2014)

Cravanzola E. – Bias cognitivi e fallace logiche: fra scienza e quotidianità (2019)

Resnick B. – A new brain study sheds light on why it can be so hard to change someone’s political beliefs (2017)

Le Scienze – Flessibilità cognitiva e scelte elettorali (2018)

Il Post – Smentire le bufale è inutile? (2015)